2025年2月13日,阿里巴巴旗下“通义灵码”宣布阿里云百炼平台支持DeepSeek-V3和 DeepSeek-R1 671B模型(满血版 ), 通义灵码支持DeepSeek-V3和R1系列模型选择,助力AI编程。

2025年2月12日,华为技术有限公司宣布基于华为云的昇腾云服务全栈优化适配DeepSeek V3 / R1 671B模型(满血版),满足商用部署需求。

DeepSeek-R1是DeepSeek发布于2025年1月20日的人工智能(Artificial Intelligence,AI)模型,专注完成复杂逻辑推理任务,DeepSeek-R1整合冷启动数据。在数学、代码和推理任务方面的性能可与OpenAI-o1相媲美。并且可商用,允许模型蒸馏。

DeepSeek-V3是DeepSeek发布于2024年12月26日的AI大语言模型,截止2025年1月末该模型累计用户达1.25亿。这是一个功能强大的混合专家(Mixture-of-Experts,MoE)语言模型,具有6710亿个参数,每个标记激活 370亿个参数。为实现高效推理和成本经济的模型训练,DeepSeek-V3采用多头潜在注意力(Multi-head Latent Attention,MLA) 和DeepSeek MoE架构,这些架构已在 DeepSeek-V2中得到全面验证。为获得更强性能,DeepSeek-V3开创用于负载均衡的辅助无损策略,并设定多标记预测训练目标。预测训练在 14.8 万亿个多样化和高质量标记上进行,然后进入监督微调和强化学习阶段。综合评估指标表明,DeepSeek-V3性能优于其他开源模型,也表现出与前沿闭源模型的竞争性能。不仅性能出色, DeepSeek-V3只需 2.788M H800 GPU小时即可完整训练。进一步,该模型训练过程非常稳定,在整个训练中未出现任何无法恢复损失峰值或执行回滚记录。

以上生成式AI领域热潮带动关联AI芯片技术关注度高涨。

目前AI芯片无严格定义,从宽泛维度人工智能应用芯片都可称为AI芯片。其特征包括新型计算范式、训练和推理、海量数据处理、低数据精度、可重构能力及软件开发工具支持。

目前AI芯片主要包括三类:

- 可支持AI应用的部分通用芯片,如GPU

为特定AI应用设计的专用芯片(Application-Specific Integrated Circuit,ASIC),主要加速机器学习进程,是目前主流AI 芯片类型

类脑结构的计算芯片,不采用经典冯·诺依曼架构,而是基于神经形态架构设计,如IBM Truenorth

随着AI应用规模扩大,传统通用芯片在性能、功耗等方面局限性日益凸显,深度学习算法稳定后, AI芯片可采用 ASIC设计方法定制, 实现指标更优。不断增长的性能需求和技术瓶颈给AI芯片技术带来两大挑战:

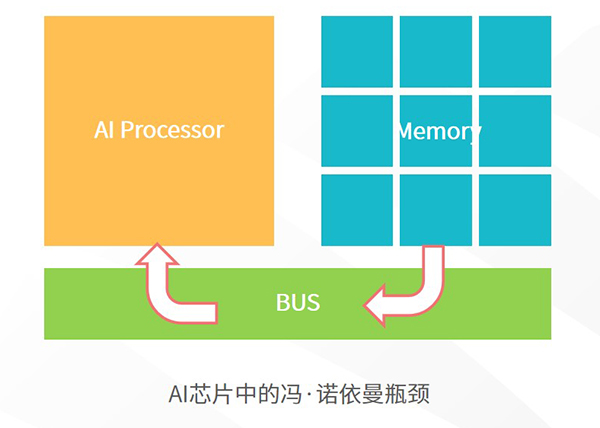

- AI 应用要求更高效处理AI 运算的硬件,关键之一是支持高速数据访问。如图3所示,在冯·诺伊曼架构中,理论上数据从存储器提取,送入运算部件处理完后,再写回存储器。由于运算和存储部件之间存在速度差异,当运算提速,访问存储器速度无法跟上运算部件速度。在这种情况下即使增加运算部件,也无法提升芯片性能,这类瓶颈问题长期困扰计算机体系结构。目前解决方案主要是减少存储器数量和降低访问存储器次数。

- AI技术发展要求计算系统速度超百亿次运算/秒,实现基础是互补金属氧化物半导体(Complementary Metal-Oxide-Semiconductor Transistor,CMOS) 技术,CMOS工艺不断提高主要依赖集成尺寸不断缩小。受物理原理和经济原因限制,进一步缩小尺寸,持续提高集成密度难度越来越高。

在计算架构和器件层面,近年来类脑结构的芯片架构为克服以上缺点提供新思路,因此热度正逐步增长。

基于以上技术方向,AI芯片发展趋势预测如下:

- 云端训练和推断:大存储、高性能、可伸缩

随着AI 应用爆发,推理计算需求会越来越多,和训练相比,推理要求更高吞吐率、能效和实时性。 - 终端设备:高效率

相比云端应用,终端应用针对不同场景和需求,复杂性更高,同时完成本地训练、优化和更新模型。这些AI 芯片往往是系统级产品(System on a Chip,SoC),AI 功能通过芯片整体体现硬件性能。因此,终端设备AI 芯片是专门AI 器件和CPU(Central Processing Unit),GPU(Graphics Processing Unit),ISP(Image Sensor Processor),DSP(Digital Signal Processor) 等部件协同工作整体。 - 软件定义芯片:动态计算

软件是实现AI计算的核心,即AI 算法,复杂AI任务要求AI芯片实时改变功能,满足软件计算动态需求。

DeepSeek优异性能和出色成本效益,推动高国产AI芯片厂商纷纷接入,同时华为云、腾讯云、阿里云等10家国内云计算企业和其他多家智算企业,都宣布对DeepSeek的支持。在模型训练阶段,强算力、高通信带宽和大容量芯片仍然代表主导技术,在模型推理阶段终端AI算力消耗低、蒸馏后小模型所需闪存较小,与国产AI芯片发展态势更匹配。同时较低售价对用户更具吸引力,国产芯片及基于国产芯片服务器厂商将迎来更高增长。据中商产业研究院发布的《2024-2029年中国人工智能芯片行业市场发展监测及投资潜力预测报告》,2025年我国AI芯片市场规将模达CNY1530亿元。

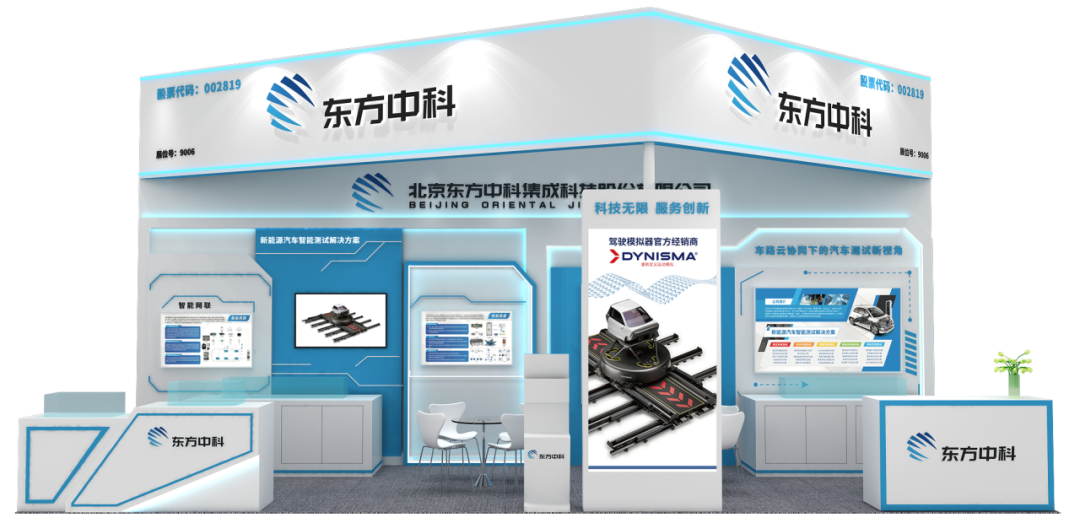

面向AI芯片领域研发主推热租测试工具:

一、KEYSIGHT UXR0134A Infiniium UXR系列示波器具有超低噪声和高信号保真度,更全面探测及分析应用软件功能,支持全方位升级。提供多带宽条件准确测量,深入洞察信号真实特性。通过硬件加速测量分析,宽带毫米波测量EVM 性能可媲美其他先进信号分析仪。因此非常适合苛刻多通道应用,例如相干光调制100G -1T+ 数据通信系统调试、PCIe 5.0技术调试、兼容DDR5 PAM4和NRZ研究等。同时支持快速缩放波形聚焦,卓越测量特性捕捉信号异常波动细节,提供全新波形调试体验。

核心参数:

- 带宽:5 -110 GHz;通道数:1、2或4 -channel

- 最大存储器深度:2 Gpts;最高采样率:256 GSa/s

- ADC位数:10位;最大DDC带宽:2.16 GHz

KEYSIGHT UXR0134A Infiniium UXR系列示波器

二、KEYSIGHT M8040A 64 Gbaud高性能比特误码率测试仪代表高度集成、可扩展误码率测试解决方案之一,可支持 PAM4 和 NRZ 信号。高达 64 Gbaud 数据速率提供精确可靠测试结果,可对标准测试接收机(输入)测试,如400 GbE、50/100/200/400/800 GbE、OIF CEI-56G/CEI-112G、64G/112G 光纤通道、Infiniband-HDR,PCIe 5、TBT3及芯片间、芯片与模块、背板、中继器和有源光纤电缆的专有接口。广泛应用于数据中心产品、计算机、消费电子等高速数字设备的性能裕量分析。

核心参数:

- 单个硬件可通过软件选择 PAM4和NRZ制式,多通道功能,灵活硬件配置选择

- 2 至 64 Gb/s 数据速率 NRZ 码型生成和误码分析

- 2 至 64 Gbaud 数据速率的 PAM4 码型生成

- 内置 2 至 64 Gbaud 时钟/数据恢复和均衡功能